Para facilitar el rastreo de un sitio web por parte de los motores de búsqueda, es fundamental optimizar tres aspectos técnicos clave: estructura del sitio, velocidad de carga y configuración del archivo robots.txt.

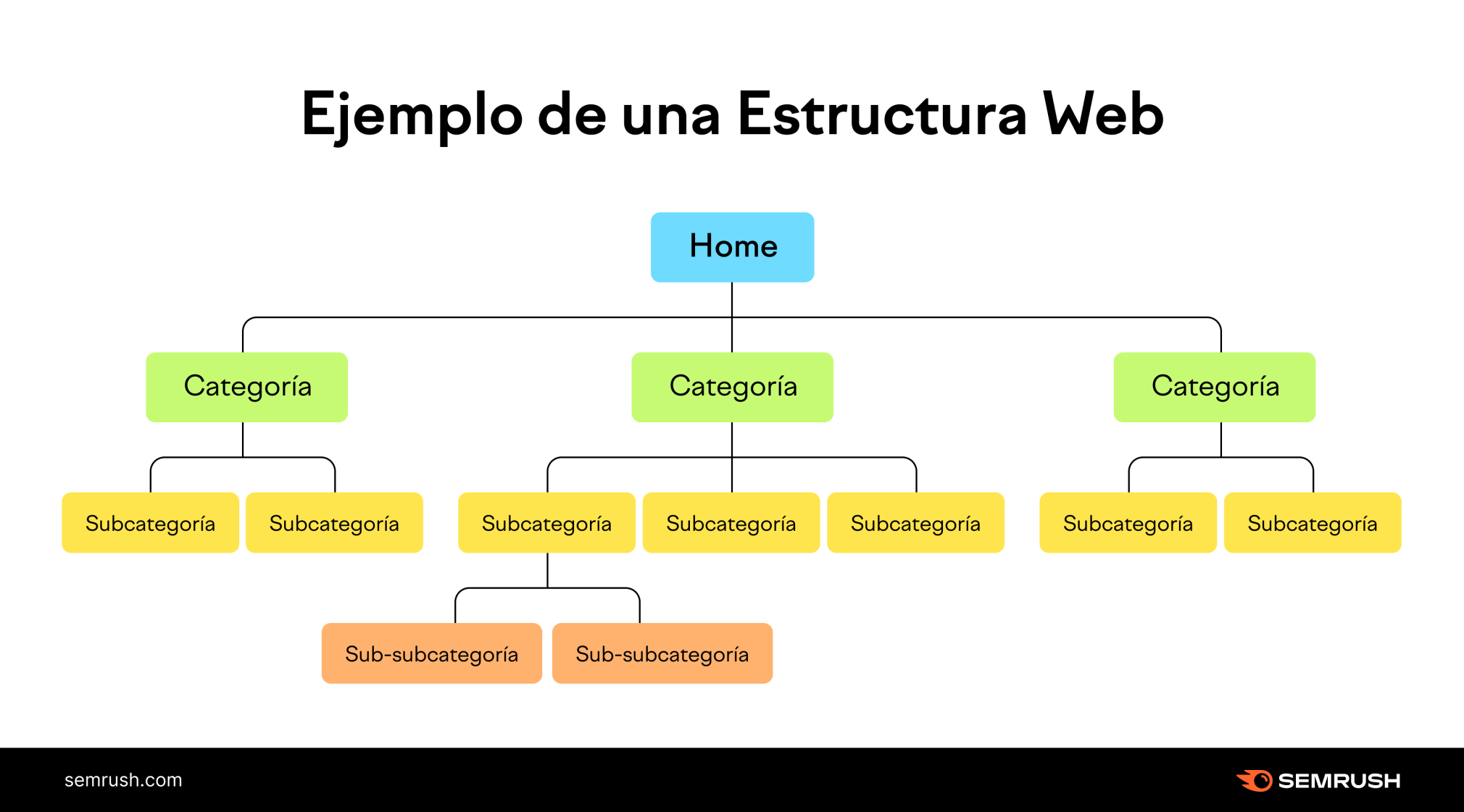

- Estructura del sitio:

- Debe ser jerárquica y clara, con una arquitectura lógica que permita a los bots y usuarios encontrar fácilmente la información. Idealmente, cada página importante debe estar a no más de tres clics desde la página principal.

- Utilizar enlaces internos bien organizados para conectar páginas relacionadas y facilitar la navegación del rastreador.

- URLs amigables, cortas, descriptivas y con guiones en lugar de guiones bajos, que ayuden a los motores de búsqueda a entender el contenido.

- Velocidad de carga:

- La rapidez del servidor y la velocidad de carga influyen directamente en la eficiencia del rastreo, ya que respuestas rápidas permiten a los bots hacer más solicitudes sin sobrecargar el servidor.

- Implementar técnicas como compresión, caching, uso de CDN y optimización de recursos para reducir la latencia.

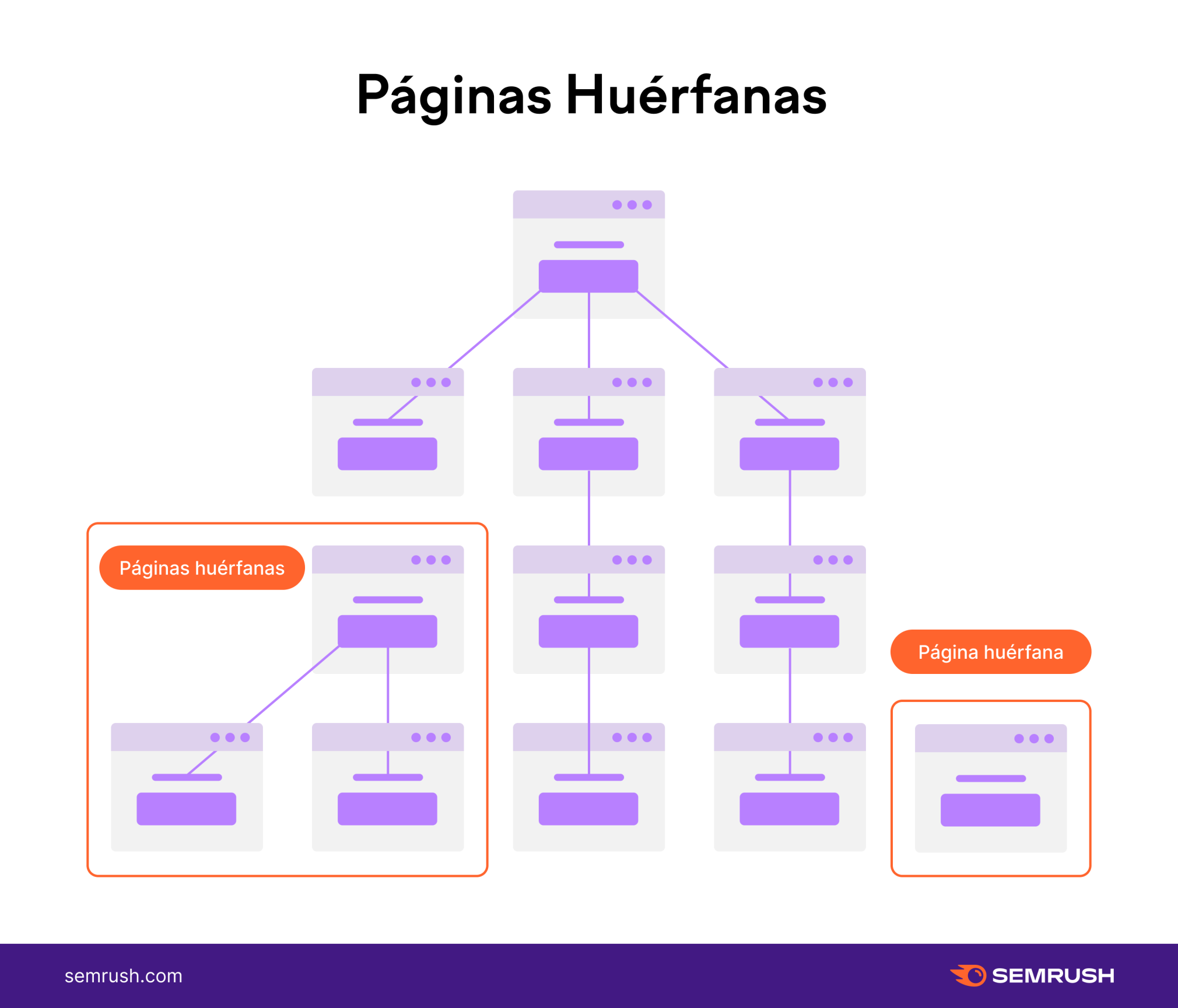

- Minimizar redirecciones y evitar páginas huérfanas o con errores 4xx/5xx para no desperdiciar el presupuesto de rastreo.

- Archivo robots.txt:

- Es un archivo de texto que indica a los motores de búsqueda qué partes del sitio pueden o no pueden rastrear, ayudando a controlar el acceso y evitar el rastreo de contenido duplicado o irrelevante.

- Debe configurarse correctamente para no bloquear páginas importantes ni recursos esenciales para la renderización.

- Su sintaxis incluye directivas para user-agents específicos y reglas de acceso a directorios o archivos, procesadas de arriba hacia abajo.

- Puede usarse para solucionar problemas técnicos o editoriales, como evitar el rastreo de páginas paginadas innecesarias.

Adicionalmente, mantener actualizados los sitemaps XML y usar etiquetas canónicas ayuda a guiar a los motores de búsqueda hacia el contenido relevante y evitar duplicidades.

En resumen, una estructura clara y jerárquica, una alta velocidad de carga y una configuración precisa del robots.txt son pilares técnicos para facilitar el rastreo eficiente y mejorar la indexación y posicionamiento SEO de un sitio web.