robots.txt 점검과 내부 링크 최적화를 통한 인덱싱 속도 향상 방법

1. robots.txt 점검 및 최적화

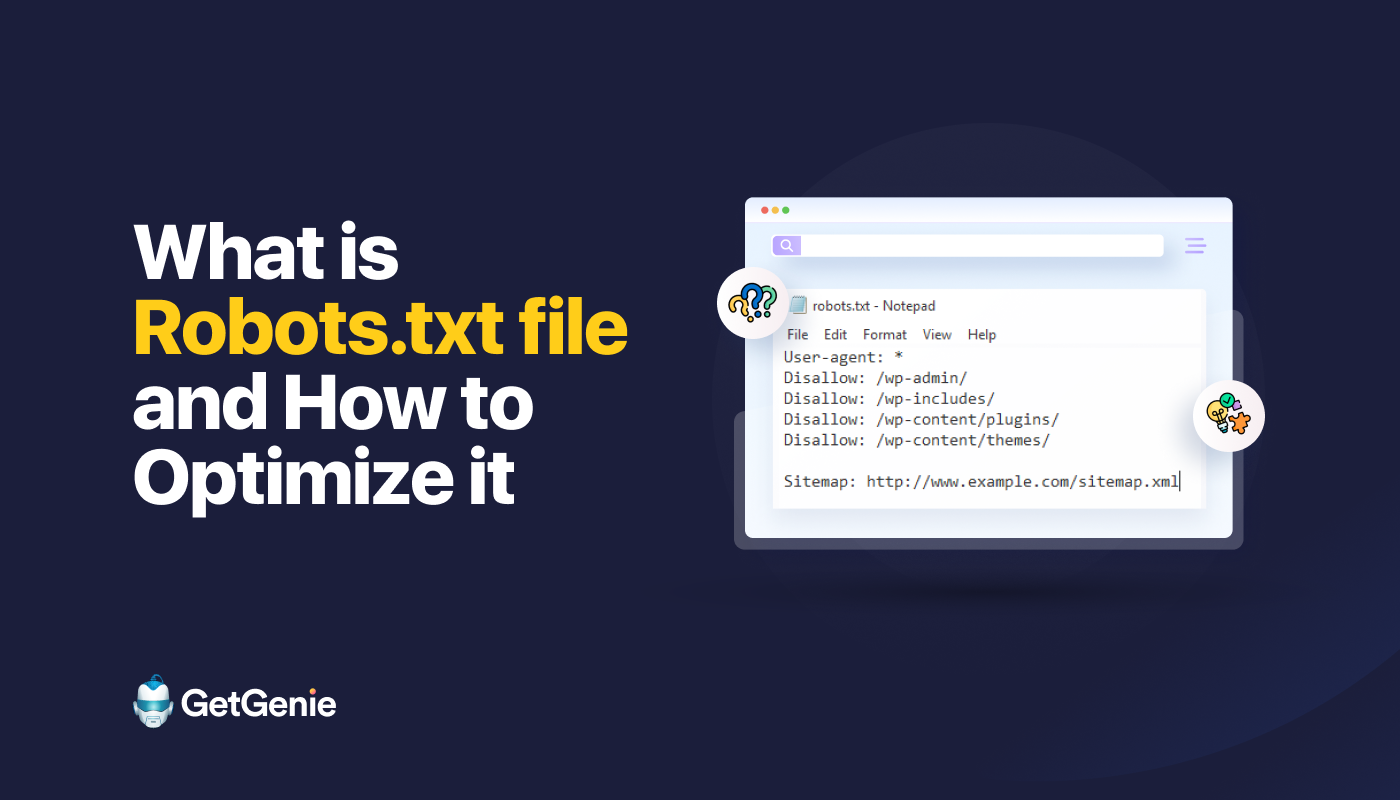

robots.txt 파일은 검색 엔진 크롤러가 웹사이트의 어떤 부분을 크롤링할 수 있는지, 어떤 부분은 제외해야 하는지를 명시하는 중요한 파일입니다. 이를 통해 불필요한 페이지가 크롤링되지 않도록 하여 서버 부하를 줄이고, 중요한 페이지가 더 잘 인덱싱되도록 할 수 있습니다.

-

지시어 사용:

User-agent,Disallow,Allow지시어를 사용하여 크롤러의 접근을 제어합니다.- User-agent: 크롤러의 이름을 지정합니다. 예:

User-agent: Googlebot - Disallow: 크롤링을 금지할 경로를 지정합니다. 예:

Disallow: /private/ - Allow: 크롤링을 허용할 경로를 지정합니다. 예:

Allow: /public/

- User-agent: 크롤러의 이름을 지정합니다. 예:

-

테스트 도구 사용: Google Search Console의 robots.txt 테스트 도구를 사용하여 파일의 유효성을 확인하고 오류를 수정합니다.

2. 내부 링크 최적화

내부 링크는 웹사이트 내의 중요한 페이지를 쉽게 찾을 수 있도록 도와주며, 이는 검색 엔진의 크롤링 효율성을 높이는 데 기여합니다.

- 핵심 페이지 연결: 핵심 페이지가 루트에서 3클릭 이내에 위치하도록 내부 링크를 설계합니다.

- 중복 콘텐츠 관리:

rel="canonical"태그를 사용하여 중복 콘텐츠를 하나로 통합합니다. - 사이트맵 제출: XML 사이트맵을 자동 갱신하고 Search Console에 제출하여 크롤러가 사이트 구조를 쉽게 이해하도록 합니다.

3. 추가 전략

- JS 기반 페이지 최적화: 초기 렌더링을 보장하기 위해 SSR(서버 사이드 렌더링) 또는 동적 렌더링을 사용합니다.

- 로그 파일 모니터링: 크롤러의 페이지당 체류 시간과 응답 코드를 정기적으로 검토하여 사이트 성능을 개선합니다.

이러한 전략을 통해 웹사이트의 인덱싱 속도를 높이고, SEO 성능을 개선할 수 있습니다.