Untuk memeriksa dan mengoptimumkan fail robots.txt dan meta tag noindex, anda perlu memastikan kedua-dua elemen ini berfungsi dengan betul untuk mengawal perayapan (crawling) dan pengindeksan (indexing) oleh enjin carian.

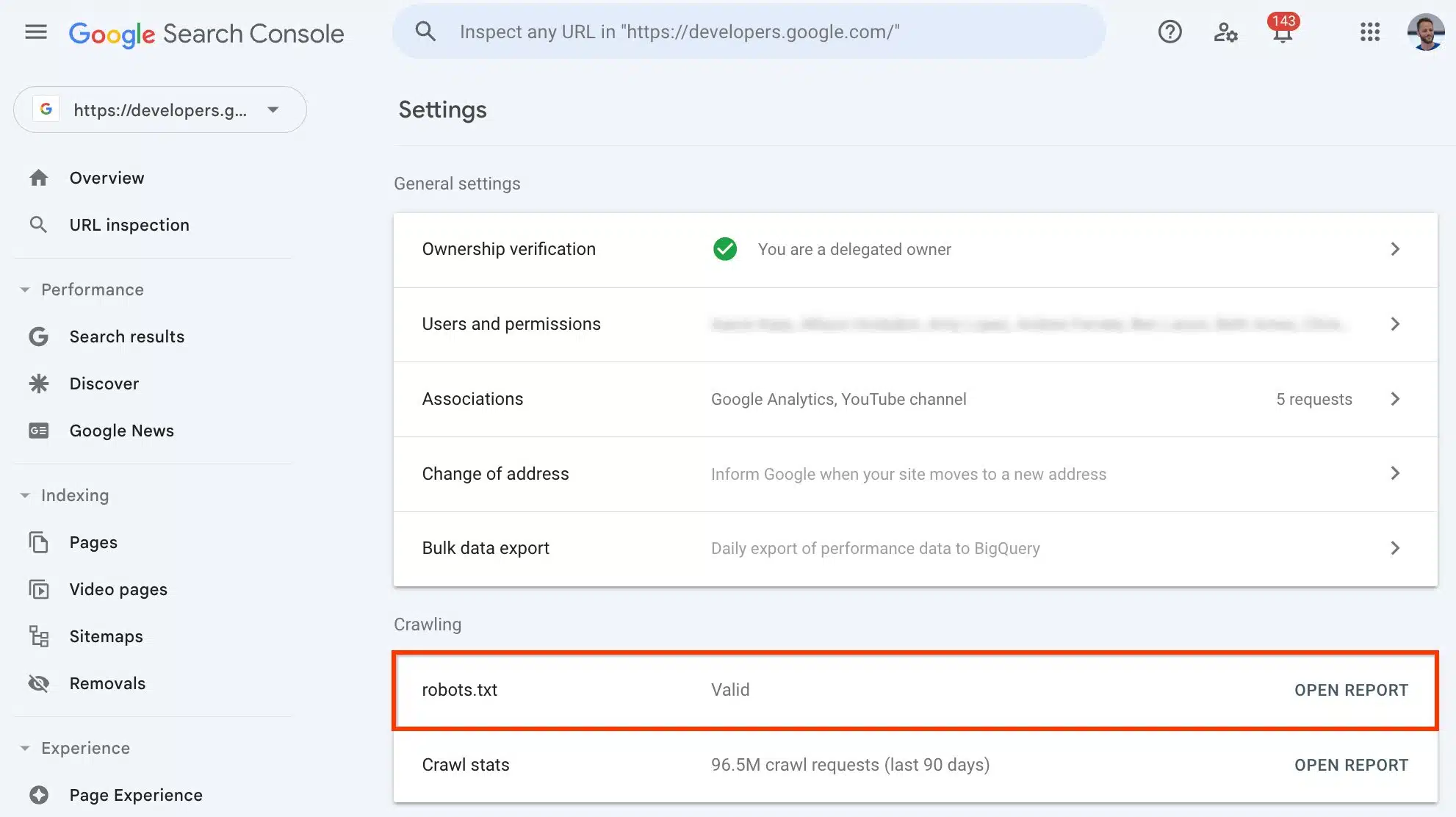

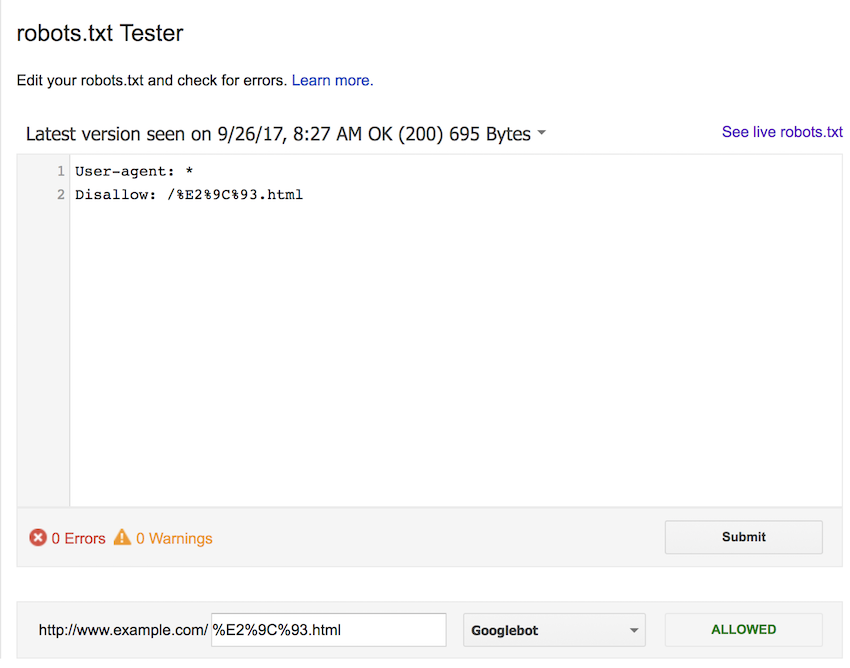

Memeriksa Fail Robots.txt:

- Fail robots.txt terletak di direktori root laman web anda, contohnya:

https://www.domainanda.com/robots.txt. Anda boleh akses terus URL ini untuk melihat kandungannya. - Gunakan alat seperti robots.txt tester di Google Search Console untuk menguji sama ada fail robots.txt anda menghalang perayapan URL tertentu dengan betul dan tiada kesalahan sintaks.

- Pastikan fail robots.txt tidak terlalu agresif menyekat halaman penting yang perlu diindeks. Fail default CMS biasanya perlu disesuaikan agar tidak menyekat sumber penting.

- Elakkan menyekat URL yang menggunakan tag kanonik kerana ini boleh mengganggu pengurusan kandungan berganda (duplicate content).

Memeriksa dan Menggunakan Meta Tag Noindex:

- Fail robots.txt hanya menghalang perayapan, tetapi tidak menjamin halaman tidak diindeks. Jika anda mahu halaman tertentu tidak diindeks, gunakan meta tag

noindexpada halaman tersebut. - Meta tag

noindexperlu diletakkan dalam kod HTML halaman, contohnya:<meta name="robots" content="noindex">. - Pastikan halaman yang ingin di-noindex tidak disekat oleh robots.txt kerana Google perlu dapat merayap halaman tersebut untuk membaca tag noindex.

- Jika halaman sudah diindeks dan anda mahu keluarkan, tambah meta tag noindex dan benarkan perayapan, kemudian tunggu Google mengemas kini indeksnya.

Langkah Optimum:

- Semak fail robots.txt untuk memastikan tiada sekatan yang tidak perlu pada halaman penting.

- Gunakan Google Search Console untuk menguji dan mengesahkan konfigurasi robots.txt.

- Tambah meta tag noindex pada halaman yang tidak mahu diindeks, dan pastikan halaman tersebut boleh dirayap.

- Periksa dan buang pautan luaran (backlink) yang mengarah ke halaman yang tidak mahu diindeks jika perlu, kerana pautan boleh menyebabkan halaman tetap diindeks walaupun disekat.

- Uji keseluruhan konfigurasi menggunakan alat validator robots.txt dan pemeriksa meta tag untuk memastikan tiada konflik atau kesilapan.

Dengan langkah ini, anda dapat mengawal dengan tepat halaman mana yang dirayap dan diindeks oleh enjin carian, sekaligus mengoptimumkan SEO laman web anda.