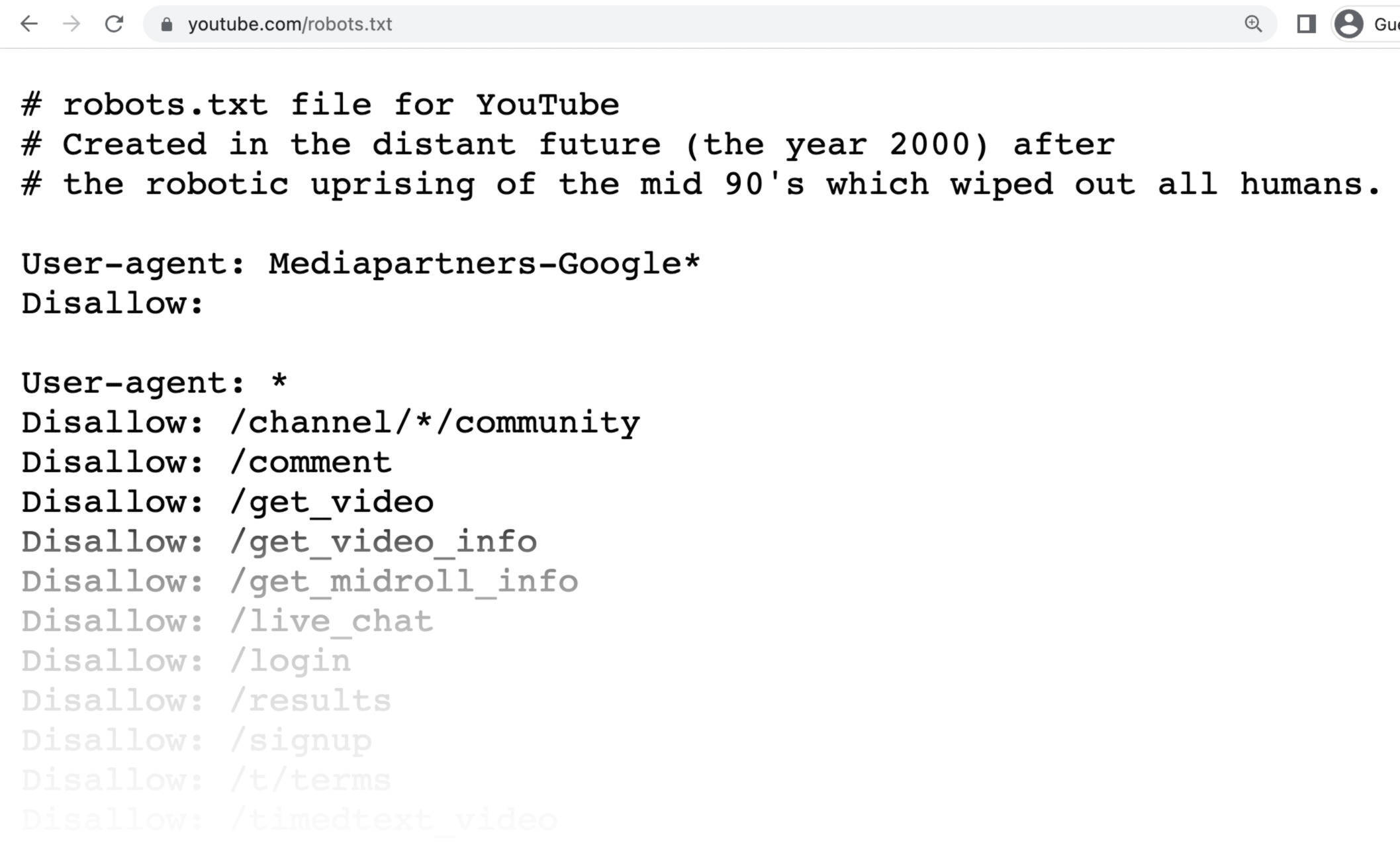

A configuração correta do arquivo robots.txt para permitir o rastreamento completo do site é simples e consiste em permitir o acesso a todos os rastreadores, sem bloqueios. O arquivo deve estar na raiz do domínio, com o seguinte conteúdo básico:

User-agent: *

Disallow:

Essa configuração indica que todos os agentes de rastreamento ("User-agent: *") têm permissão para acessar todas as páginas do site, pois o comando Disallow: está vazio, ou seja, não há restrições de acesso.

Detalhes importantes sobre o arquivo robots.txt:

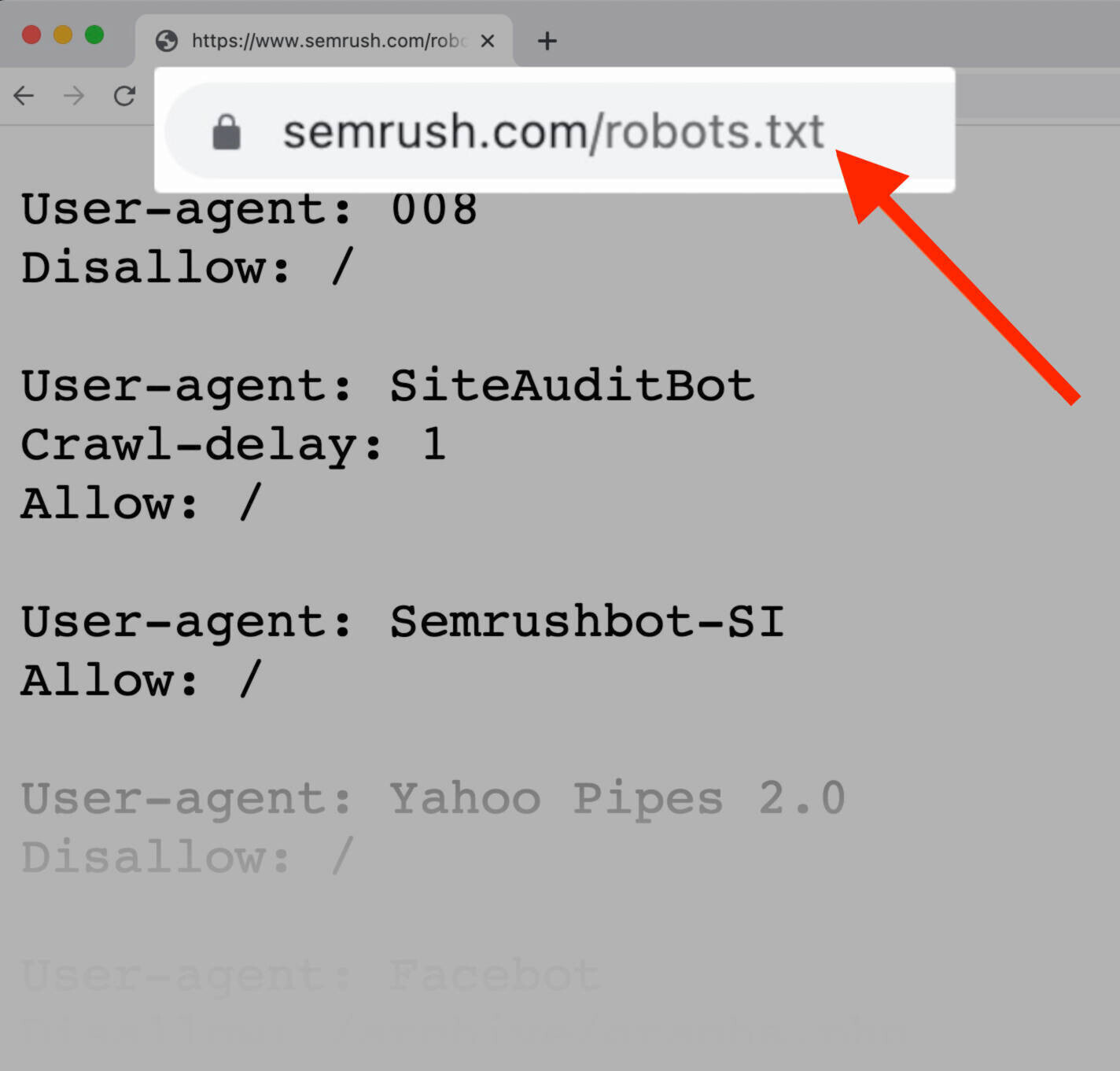

- O arquivo deve estar acessível em

https://www.seusite.com/robots.txt(na raiz do domínio). - A diretiva

User-agent: *aplica-se a todos os robôs de busca, como Googlebot, Bingbot, etc.. - O comando

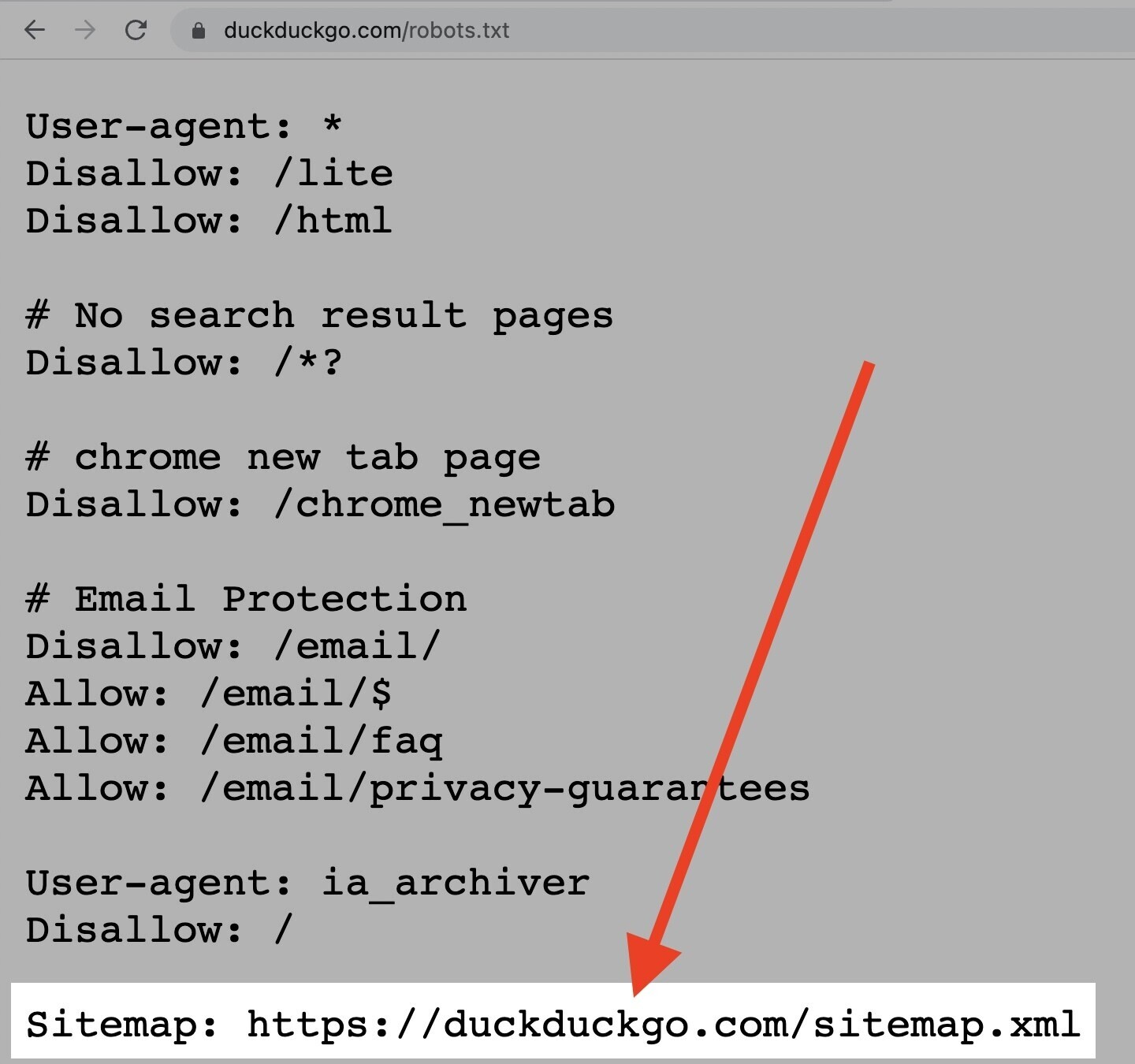

Disallow:vazio significa que nenhuma URL está bloqueada para rastreamento, permitindo o acesso total. - É possível adicionar a localização do sitemap XML para facilitar a indexação, por exemplo:

Isso não controla o rastreamento, mas ajuda os buscadores a encontrar as páginas do site.Sitemap: https://www.seusite.com/sitemap.xml - Caso queira bloquear algum diretório ou página específica, usa-se

Disallow: /caminho/para impedir o acesso a essa parte do site.

Exemplo completo para permitir rastreamento total e informar o sitemap:

User-agent: *

Disallow:

Sitemap: https://www.seusite.com/sitemap.xml

Observações adicionais:

- Se o arquivo robots.txt não existir, os rastreadores assumem permissão total para rastrear o site.

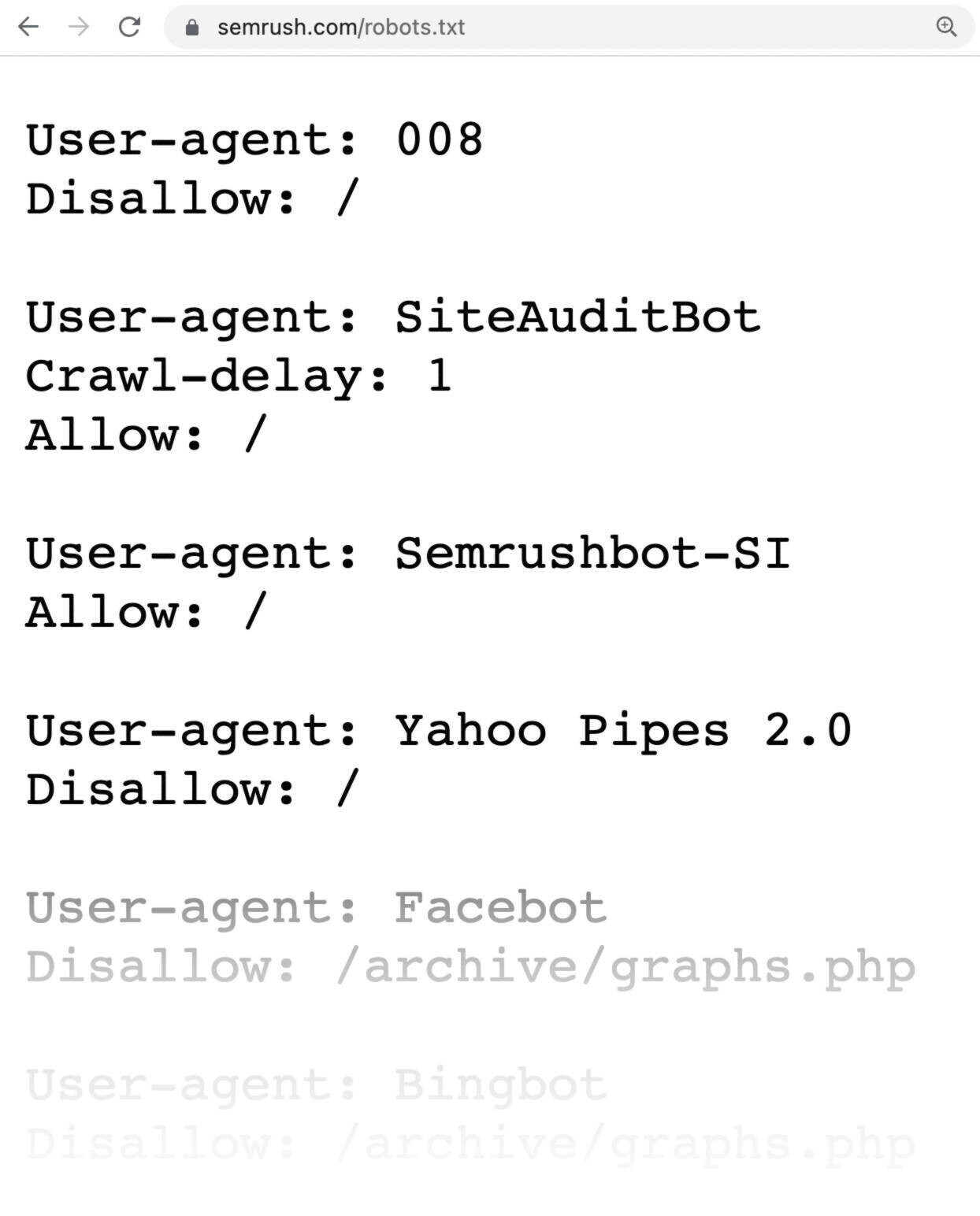

- Para permitir rastreamento de bots específicos e bloquear outros, você pode criar grupos separados com regras específicas para cada

User-agent. - Após atualizar o arquivo robots.txt, os rastreadores podem levar algum tempo para detectar as mudanças, pois atualizam a versão em cache periodicamente.

Portanto, para permitir o rastreamento completo do seu site, basta criar um arquivo robots.txt com as duas linhas acima, garantindo que ele esteja na raiz do domínio e acessível publicamente.