Avant la mise en ligne d’un site web, il est essentiel de préparer plusieurs aspects techniques clés : l’hébergement, la mise en place du certificat SSL, la création du sitemap XML et la configuration du fichier robots.txt.

Hébergement : Choisissez un hébergeur fiable adapté à votre type de site (vitrine, e-commerce, etc.) et à votre trafic attendu. L’hébergement doit garantir la disponibilité, la rapidité et la sécurité de votre site. Il faut réserver un nom de domaine et configurer l’hébergement pour y déployer les fichiers du site.

Certificat SSL : Installer un certificat SSL (HTTPS) est indispensable pour sécuriser les échanges entre le serveur et les visiteurs, protéger les données sensibles et améliorer le référencement naturel. Le certificat SSL doit être configuré sur le serveur avant la mise en ligne pour éviter les erreurs de sécurité.

Sitemap XML : Ce fichier liste toutes les pages importantes de votre site pour aider les moteurs de recherche à mieux explorer et indexer votre contenu. Il peut être créé automatiquement via des outils ou plugins (ex. SEOPress pour WordPress) ou manuellement. Le sitemap doit être placé à la racine du site et soumis à Google Search Console pour optimiser la visibilité.

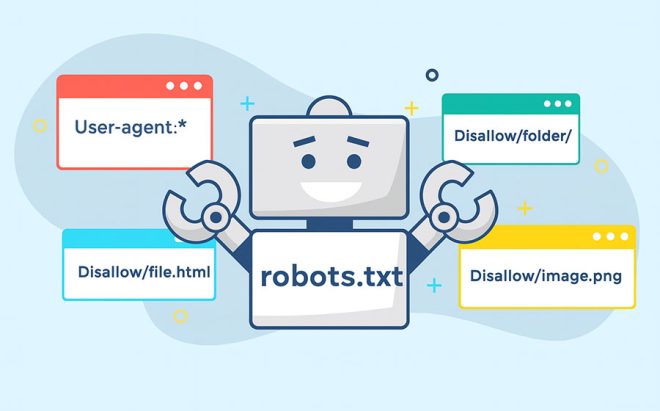

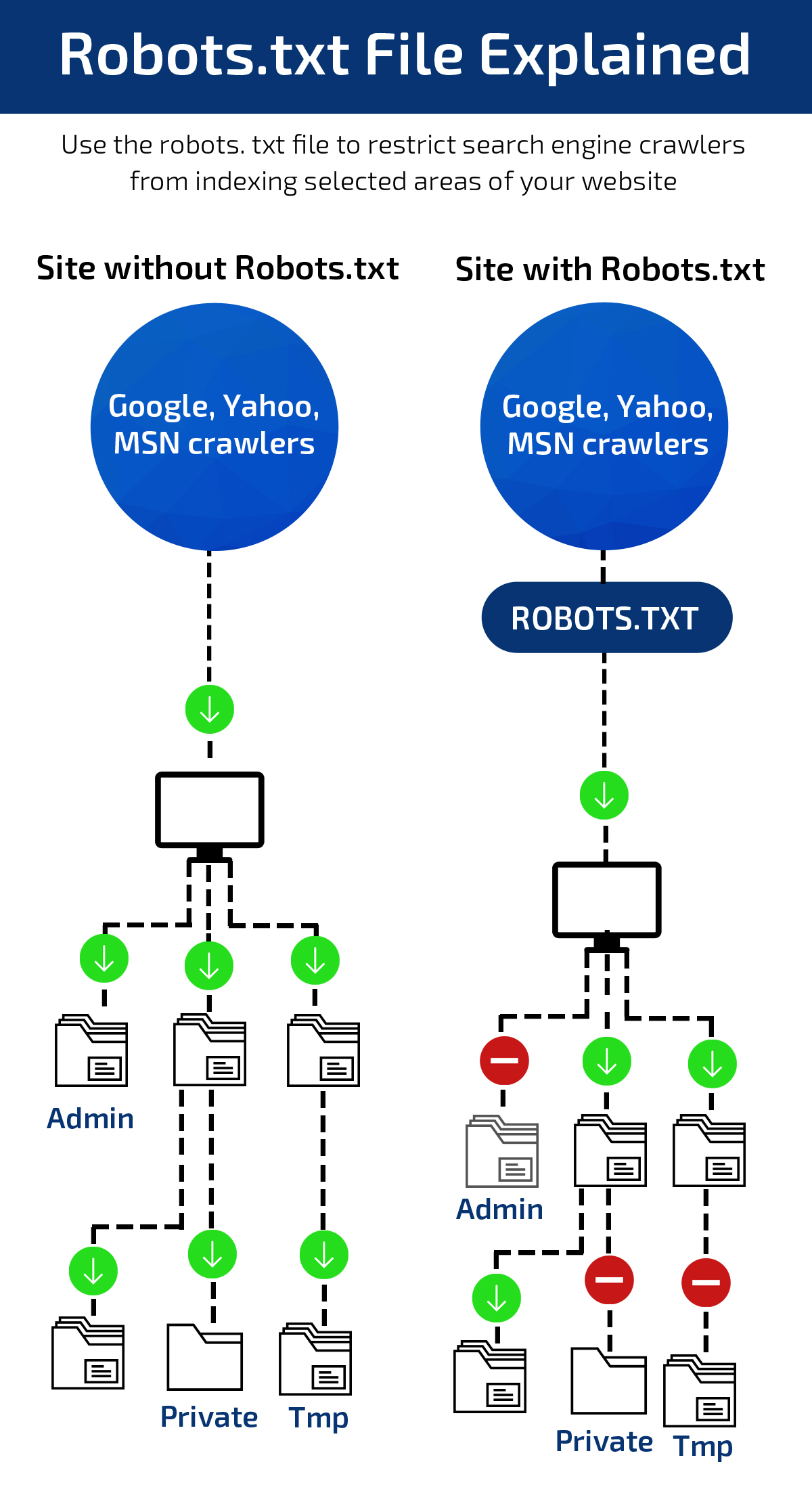

Fichier robots.txt : Ce fichier texte indique aux robots des moteurs de recherche quelles pages ou sections du site ils peuvent explorer ou doivent ignorer. Il est créé avec un éditeur de texte simple, placé à la racine du site, et doit contenir des directives claires (Disallow: pour bloquer, Allow: pour autoriser). Il est conseillé de tester ce fichier via des outils en ligne ou Google Search Console avant la mise en production.

En résumé, la préparation technique avant mise en ligne comprend :

-

Choix et configuration de l’hébergement et du nom de domaine.

-

Installation et activation du certificat SSL pour sécuriser le site.

-

Création et soumission du sitemap XML pour faciliter l’indexation.

-

Rédaction, placement et test du fichier robots.txt pour contrôler le crawl des moteurs.

Ces étapes garantissent une base solide pour la visibilité, la sécurité et la performance du site dès son lancement.