Erreurs courantes qui retardent l’indexation

Plusieurs erreurs techniques et stratégiques peuvent ralentir, voire empêcher, l’indexation de votre site par les moteurs de recherche. Voici les principales à éviter, avec des explications concrètes et des pistes de correction.

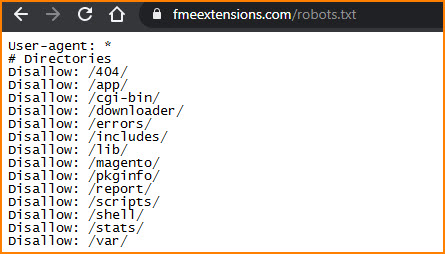

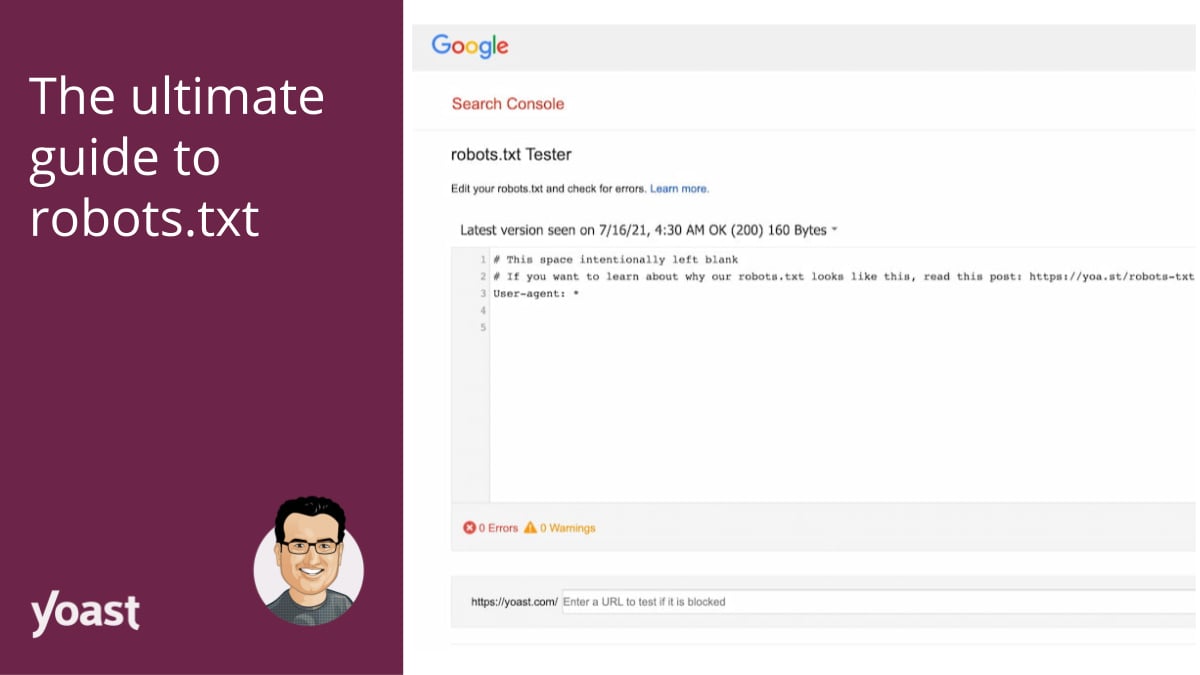

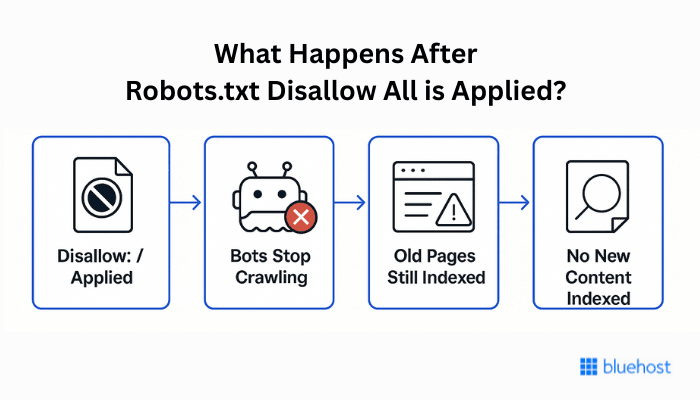

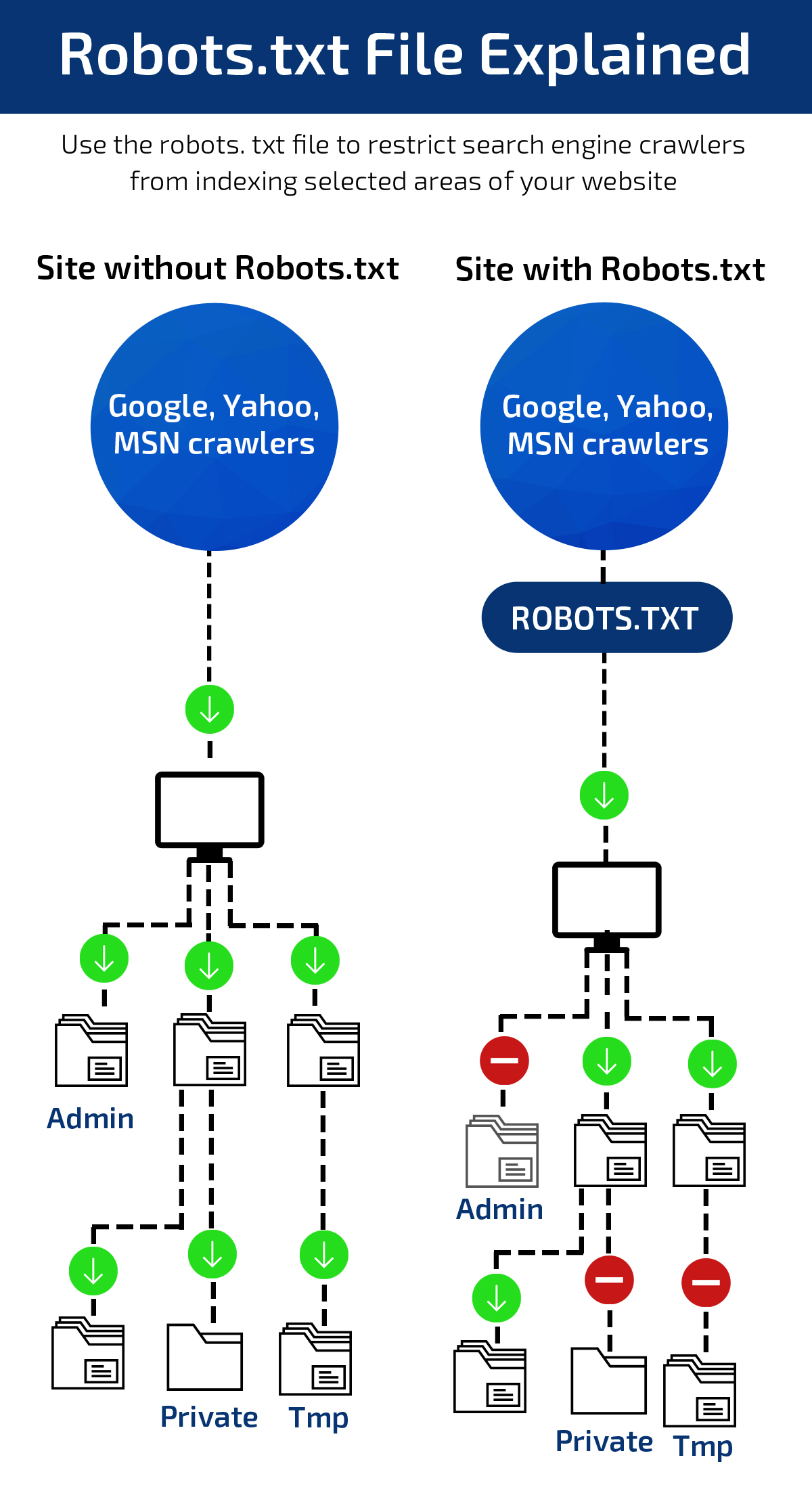

Fichier robots.txt mal configuré

Le fichier robots.txt indique aux robots des moteurs de recherche quelles pages ils peuvent ou non explorer. Une mauvaise configuration peut bloquer l’accès à des pages importantes, les rendant invisibles pour l’indexation.

Erreurs fréquentes :

- Placer le fichier robots.txt ailleurs qu’à la racine du site.

- Utiliser une syntaxe incorrecte ou des règles trop restrictives (par exemple, bloquer toute une section du site par erreur).

- Bloquer par inadvertance des pages stratégiques (pagination, pages de résultats de recherche, etc.).

- Ne pas spécifier l’emplacement du sitemap dans le robots.txt, ce qui complique la découverte des pages par les robots.

Solution :

Vérifiez régulièrement votre fichier robots.txt avec des outils comme Google Search Console ou Screaming Frog pour détecter les pages bloquées à tort. Assurez-vous que seules les pages non pertinentes (fichiers techniques, pages de test, etc.) sont exclues.

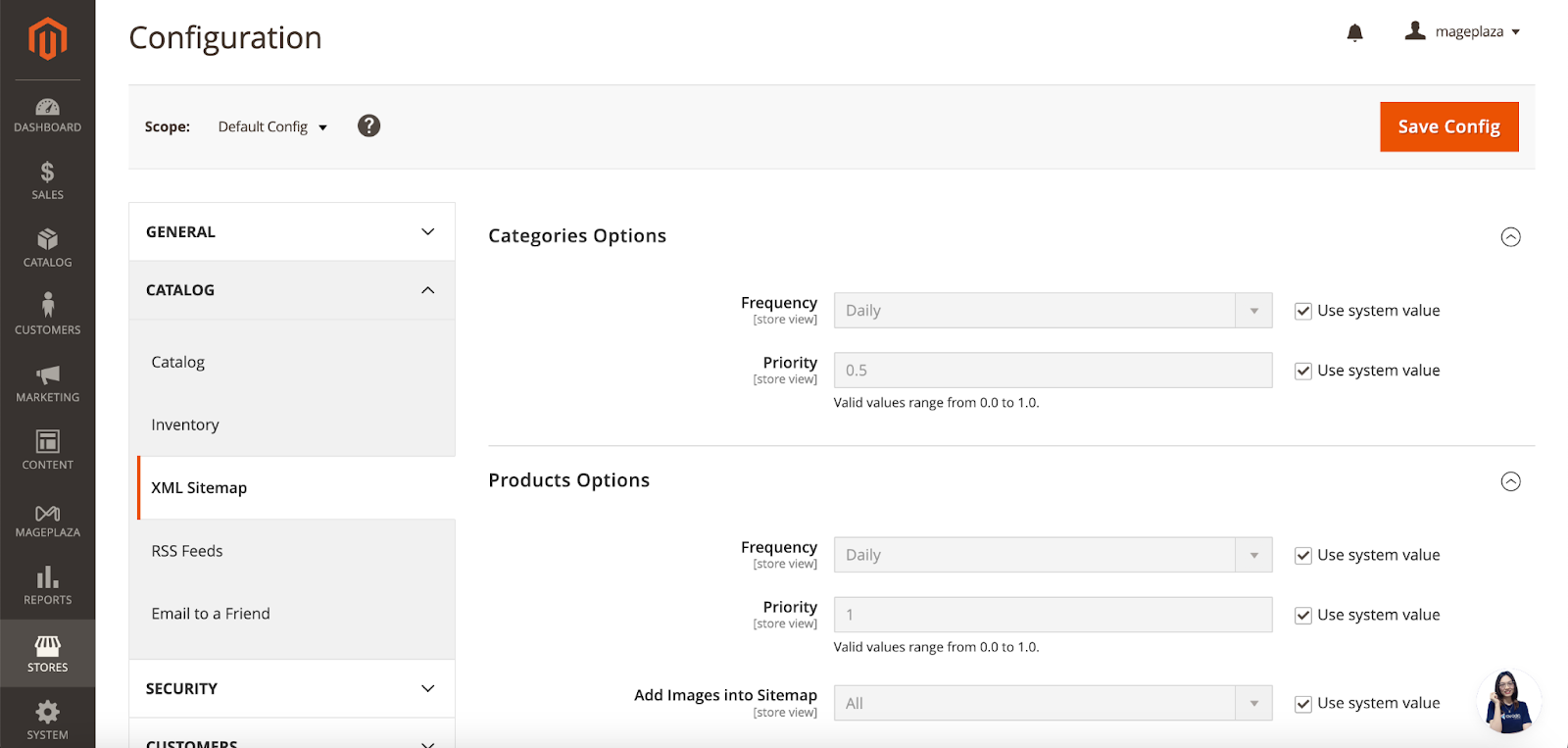

Absence de sitemap XML

Le sitemap XML aide les moteurs de recherche à comprendre la structure de votre site et à découvrir toutes vos pages, surtout celles peu ou mal liées en interne.

Conséquences de l’absence de sitemap :

- Certaines pages peuvent être ignorées ou indexées très tardivement.

- Les robots passent à côté de contenus stratégiques, surtout sur les sites volumineux ou complexes.

Solution :

Générez un sitemap à jour (automatiquement si possible) et soumettez-le via Google Search Console. Ajoutez également une référence à votre sitemap dans le fichier robots.txt pour faciliter sa découverte.

Contenu dupliqué

Le contenu dupliqué (identique ou très similaire sur plusieurs URL) perturbe les moteurs de recherche, qui ne savent pas quelle version indexer ou classer.

Exemples courants :

- Pages produit e-commerce avec des variations minimes (couleur, taille).

- Pages avec et sans « www », avec ou sans slash final, ou en HTTP/HTTPS.

- Contenu copié d’autres sites ou réutilisé massivement en interne.

Solution :

Utilisez la balise canonical pour indiquer la version préférée d’une page. Optimisez les URLs (courtes, sémantiques, uniques). Évitez la duplication inutile et privilégiez des contenus originaux.

Manque de liens externes (backlinks)

Les liens externes (backlinks) provenant d’autres sites sont un signal de confiance pour les moteurs de recherche. Un site sans backlinks, ou avec des backlinks de mauvaise qualité, peut voir son indexation ralentie et son classement pénalisé.

Conséquences :

- Faible autorité perçue par les algorithmes.

- Difficulté à faire découvrir de nouvelles pages, surtout pour les sites récents ou peu connus.

Solution :

Développez une stratégie de netlinking naturelle (partenariats, contenus de qualité partageables, présence sur des annuaires spécialisés). Évitez les pratiques de liens artificiels ou spammy, sanctionnées par Google.

Tableau récapitulatif des erreurs et solutions

| Erreur | Conséquence sur l’indexation | Solution recommandée |

|---|---|---|

| robots.txt mal configuré | Pages bloquées, non explorées | Vérifier et corriger la syntaxe, tester l’accès |

| Absence de sitemap XML | Pages ignorées ou indexées tardivement | Générer et soumettre un sitemap à jour |

| Contenu dupliqué | Confusion des robots, dilution du classement | Balise canonical, URLs uniques, contenu original |

| Manque de liens externes | Faible autorité, indexation ralentie | Stratégie de netlinking naturelle |

Bonnes pratiques complémentaires

- Vérifiez régulièrement les rapports d’indexation dans Google Search Console pour détecter les erreurs techniques (pages bloquées, erreurs 4xx/5xx, etc.).

- Optimisez la structure technique du site (temps de chargement, version mobile, maillage interne).

- Soignez les balises title et meta description pour améliorer le taux de clic et la pertinence perçue.

- Respectez une hiérarchie de titres (H1, H2, H3…) pour une meilleure compréhension sémantique par les robots.

En évitant ces erreurs courantes, vous maximisez les chances que votre site soit correctement et rapidement indexé, ce qui est la base d’un référencement naturel efficace.